I dossier sono la base per portare un farmaco sul mercato e regolamentarlo. Tuttavia, la mole di documenti che li compone rende difficile individuare con rapidità le informazioni necessarie, ostacolando la capacità dell’azienda di rispondere in tempi brevi alle richieste degli enti preposti al controllo. Un nostro cliente ci ha chiesto di aiutarlo a risolvere il problema con uno strumento per recuperare le informazioni conservate in migliaia di dossier, senza doverli scartabellare uno per uno. Ecco com’è andata.

Il nostro cliente, un gruppo farmaceutico internazionale, aveva grandi difficoltà nel recuperare le informazioni contenute nei dossier, ossia i fascicoli che raccolgono migliaia di documenti tecnici, clinici e normativi indispensabili per ottenere le autorizzazioni al commercio di un farmaco e garantirne la corretta regolamentazione.

Il problema consisteva quindi nel reperire in tempi brevi i dati necessari a soddisfare le richieste degli enti regolatori.

Ogni quesito comportava la ricerca di riferimenti puntuali all’interno dei dossier; un’operazione che costringeva gli utenti a sfogliare manualmente decine di migliaia di file, anche quando partivano da una ricerca iniziale in Veeva CRM.

Il sistema consente soltanto una ricerca tradizionale, basata sull’uso di parole chiave.

È utile per individuare i documenti potenzialmente rilevanti, ma non sufficiente a trovare subito l’informazione di interesse.

Di conseguenza, gli utenti dovevano aprire uno a uno i file individuati dal sistema, scorrerne le pagine e individuare da soli le informazioni richieste.

Ne derivava un processo lungo e dispendioso, soggetto a frequenti errori, che metteva a rischio la capacità dell’azienda di:

Per ridurre le numerose inefficienze di questo processo, abbiamo sviluppato una soluzione che prevede l’utilizzo di una chat con tecnologia RAG, integrata direttamente nel CRM aziendale basato su Veeva.

Il funzionamento è semplice, ma sofisticato.

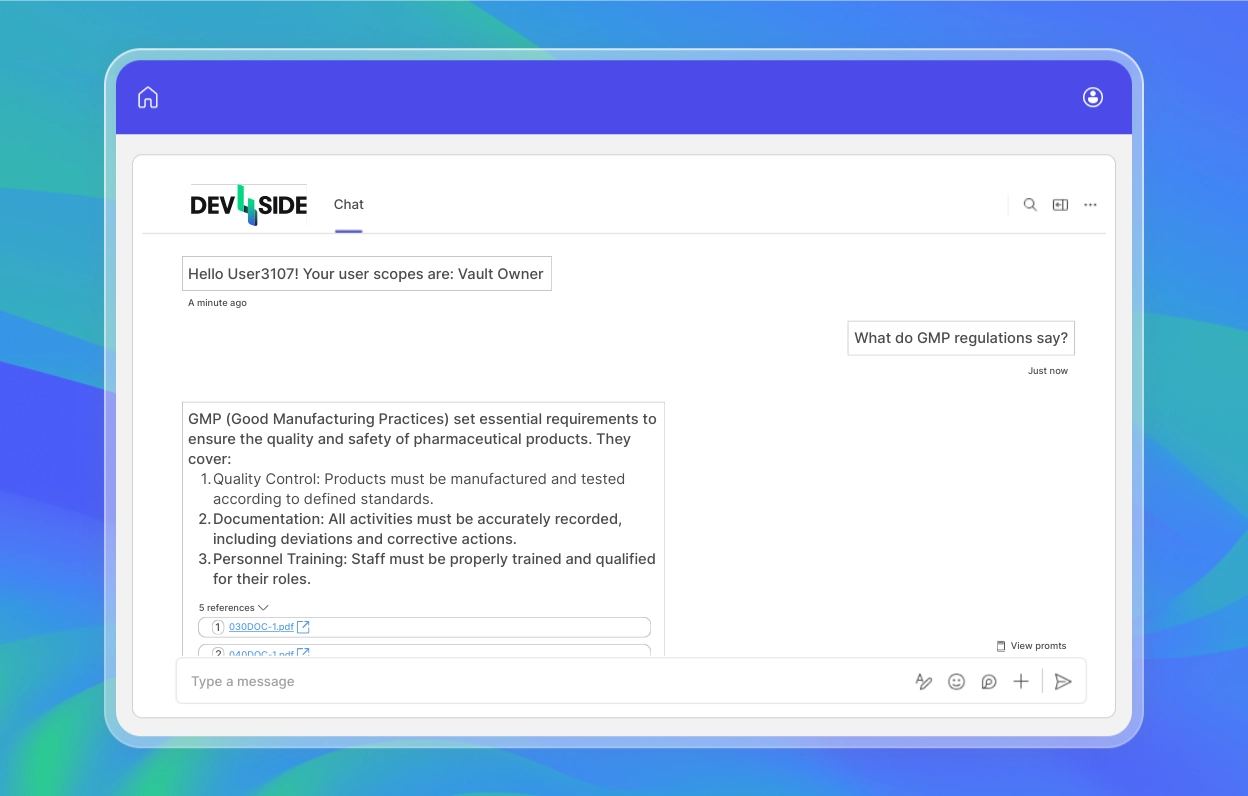

Gli utenti possono fare domande al chatbot come se stessero parlando a un collega, attraverso una chat conversazionale. L’intelligenza artificiale elabora la richiesta, si collega a Veeva Vault (il repository documentale dell'azienda) tramite Veeva CRM e genera la sua risposta.

A differenza della ricerca tradizionale, che restituisce un elenco di documenti, il chatbot fornisce l’informazione richiesta, già estratta dai dossier aziendali e arricchita da link al documento originale, così che l’utente possa verificare o approfondire ciascuna risposta.

Dietro le quinte, la nostra soluzione sfrutta le capacità di Azure AI Search per indicizzare i dossier, trasformandone i contenuti in dati “digeribili” dal chatbot.

Quando arriva una domanda, questa viene infatti confrontata con l’indice e il modello generativo riceve come contesto i passaggi più rilevanti. In questo modo, il chatbot è in grado di restituire in una manciata di secondi una risposta precisa, fondata sui dati presenti nella knowledge base aziendale.

In più, l’intero processo avviene senza abbandonare l’ambiente di Veeva CRM.

Il cuore della nostra soluzione è indubbiamente la Retrieval-Augmented Generation, e non tutti potrebbero sapere di cosa stiamo parlando.

La Retrieval-Augmented Generation è un’architettura che combina i modelli linguistici di grandi dimensioni con sistemi intelligenti specializzati nel recupero dati, per fornire risposte più precise e contestualizzate, basate direttamente sulla knowledge base interna a un’azienda.

Supera così i limiti degli LLM tradizionali, come ChatGPT, che si basano su grandi insiemi di dati generici, non controllati né costantemente aggiornati, e che spesso non riescono a fornire risposte pertinenti a esigenze specifiche, come quelle dei lavoratori.

L’intelligenza artificiale generativa comune ha infatti già dimostrato di essere utile, ma in ambito aziendale incontra ancora tre importanti ostacoli:

È qui che entra in gioco la RAG.

Invece di limitarsi a generare risposte basate sulla memoria del modello, la RAG integra un motore di ricerca semantico capace di recuperare in tempo reale i contenuti più rilevanti dai documenti aziendali.

Con un approccio di questo tipo, una soluzione come il nostro chatbot non “inventa” la risposta, ma restituisce esattamente le informazioni di cui l’utente ha bisogno, semplificandone il lavoro.

Per saperne di più, dai uno sguardo al nostro progetto "Retrieval-Augmented Generation, con Azure OpenAI”.

La soluzione è stata adottata subito da tutto il personale.

Non solo grazie al template creato dal nostro team, che permette di accelerare lo sviluppo di soluzioni RAG su misura, ma anche per la semplicità dell’interfaccia conversazionale e per l’integrazione diretta con Veeva CRM, già noto ai lavoratori.

Fin dai primi giorni di utilizzo, il cliente ha espresso grande soddisfazione, soprattutto per la drastica riduzione del tempo speso nella ricerca delle informazioni.

Un’attività che prima richiedeva minuti, se non ore, di consultazione manuale oggi avviene in pochi secondi, con risposte basate esclusivamente su una documentazione verificata.

Inutile sottolineare come l’ottimizzazione di questo singolo processo abbia portato a:

Il team Modern Apps risponde con prontezza alle necessità IT in cui lo sviluppo software rappresenta la componente principale, includendo soluzioni che integrano l’intelligenza artificiale. Le figure tecniche hanno una formazione mirata alla realizzazione di progetti software su stack tecnologici Microsoft e possiedono competenze nella gestione di progetti agili o di lunga durata.